Träna ett neuronnät i Matlab och exportera det till Tensorflow, och tvärtom. Det är en av många nyheter om maskininlärning i release 2018b av utvecklingsverktygen Matlab och Simulink från Mathworks.

Träna ett neuronnät i Matlab och exportera det till Tensorflow, och tvärtom. Det är en av många nyheter om maskininlärning i release 2018b av utvecklingsverktygen Matlab och Simulink från Mathworks.

Version 2018b av Matlab och Simulink släpps idag. Flera av nyheterna handlar om maskininlärning.

Den kanske mest synliga nyheten är en namnändring. Sedan åtminstone 1992 har Matlab haft en verktygslåda kallad ”Neural Network Toolbox”. Den döps härmed om till ”Deep Learning Toolbox”.

Just det. Det som idag kallas djup maskininlärning kallades på farfars tid för ”artificiella neuronnät”. Matlabs gamla namn på verktygslådan var en påminnelse om att Mathworks var tidigt inne i matchen – långt innan deep learning-vågen.

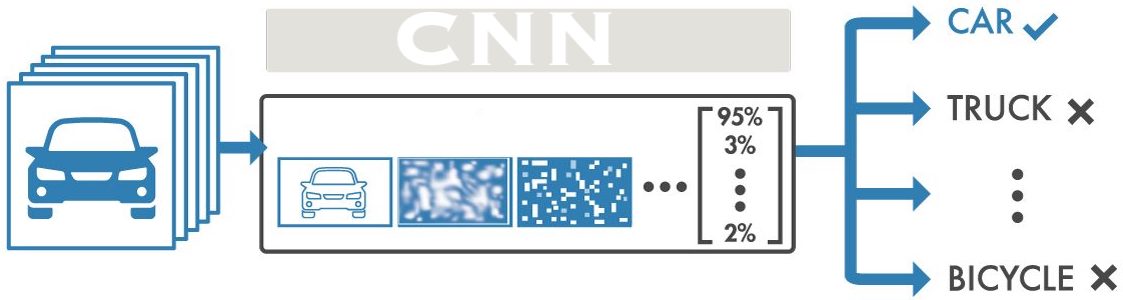

Maskinlärning används för bland annat bildbehandling, datorseende och signalbehandling. Version 2018b ska enligt Mathworks dels göra det enklare att utveckla neuronnät som är komplexa, och dels trimma deras prestanda.

MathWorks har anslutit sig till det öppna ekosystemet ONNX och stöder dess metoder för kompatbilitet mellan olika AI-plattformsvärldar. Det finns en ONNX-konverterare i R2018b som importerar och exporterar modeller (artificiella neuronnät) till och från Pytorch, Mxnet och Tensorflow.

Efter import av ett tränat nät, kan du fortsätta att utveckla, felsöka och validera det, vidare hela vägen till att stoppa in det i ett inbyggt system.

En uppsättning referensneuronnätsmodeller finns färdiga att anropa. Du kan dessutom träna om dem, vilket kan vara ett effektivt sätt att dra ner träningstiden om dina data är av standardtyp, exempelvis egna bildobjekt. Det kallas transfer learning.

I en app kallad Deep Network Designer kan du skapa egna komplexa nätverksarkitekturer.

Neuronnätsträning är en beräkningsintensiv algoritm och du kan nu delegera den till molnet – såväl till Nvidia GPU Cloud som till Amazon Web Services och Microsoft Azure.

Det finns också nytt stöd för att hjälpa dig skapa referensdata, för att etikettera ljud, video och annan rådata.

R2018b ger bättre stöd för att generera Nvidia Cuda-kod för neuronnätsinferenser genom nytt stöd för Nvidia-bibliotek och nya optimeringar som automatisk justering, lagerfusion och buffertminimering.

Dessutom har distributionssupport lagts till för Intel- och Arm- plattformar som använder Intel MKL-DNN och Arm Compute Library.

R2018b finns nu.

Här hittar du en video med en översikt av nyheterna (länk).